Optymalizowanie konwersji na stronie internetowej przy użyciu testów A/B w większości przypadków wymaga użycia odpowiedniego narzędzia. W innym wpisie zamieszczę porównanie plusów i minusów najpopularniejszych opcji (znajdzie się też miejsce dla polskich rozwiązań, które bez kompleksów gonią czołówkę), teraz skupimy się na walce między dwoma głównymi algorytmami – klasycznym, oraz na algorytmie wielorękiego bandyty. Ten drugi jest promowany przez Google jako najlepszy z dostępnych i stoi w opozycji do niemal wszystkich pozostałych systemów. Czy należy przekreślić płatne rozwiązania i korzystać wyłącznie z eksperymentów Google Analytics?

Eksperymenty Google Analytics vs Optimizely vs VWO – różnica w algorytmie

Zasada działania testów A/B (szerzej tutaj) polega na równoległym testowaniu dwóch wersji strony www lub landing page w celu znalezienia przewagi jednej z wersji. Przewagę najczęsciej mieży się w postaci konwersji – czyli wskaźnika procentowego mówiącego, ile osób na 100 wchodzących na daną stronę wykonało porządaną przez nas akcję. Konwersja 5% w sklepie internetowym oznacza, że co dwudziesta (5 na 100) osoba dokonuje zakupu. Optymalizacja konwersji może być ekstremalnie zyskowna. Załóżmy, że nasz sklep robi miesięcznie 5 milionów złotych obrotu. Jeśli zwiększymy konwersje dwukrotnie (np z 1,5% do 3%), sklep zaczyna zarabiać 10 milionów co miesiąc. Daje to wzrost o 60 milionów rocznie, a jedyne co uległo zmianie to strona www! Tak gwałtowne wzrosty są rzadkością, ale dają obraz jak ważna jest optymalizacja strony pod kątem konwersji.

Rzadziej (lub wcale) mówi się niestety o tym, ile możemy na tym stracić. W powyższym przykładzie – jeśliby nasz współczynnik spadł o połowę w wyniku niekorzystych zmian na stronie, stracimy połowę naszych przychodów, czyli 2,5 mln złotych każdego miesiąca. W niektórych przypadkach może to doprowadzić nawet do bankructwa (np. jeśli wydajemy na reklamę 4 miliony co miesiąc).

Nie wszystko da się jednak przewidzieć. Eksperymenty marketingowe nie dają pewności poprawienia sytuacji – gdyby dawały nie byłyby eksperymentami. Jeśli testujemy coś nieszablonowego lub dokonujemy poważnych zmian w układzie strony – wyniki mogą nie być zgodne z oczekiwaniami. W klasycznych testach A/B problem ten wydaje się być poważny i pozornie może kosztować dużo.

Klasyczne testy A/B rozdzielają ruch równo między wersje testowane

W klasycznych testach każda z wersji testowanych otrzymuje taki sam ruch (chyba, że zdefiniujemy inaczej), czyli po 50%. Jeśli prowadzimy test przez miesiąc, to połowa naszego ruchu trafia na gorszą wersję. Pół biedy, jeśli gorsza okazę się wersja pierwotna, a nie ta poprawiona przez nas – wtedy w ogólnym rozrachunku wyszliśmy na plus. Gorzej, jeśli zmienimy coś i wyniki okażą się gorsze niż przed zmianą. Wówczas nie tylko nie zyskaliśmy, ale wręcz straciliśmy w stosunku do sytuacji, w której nie robilibyśmy nic.

Tutaj pojawiają się eksperymenty Google Analytics. Oparte są na algorytmie minimalizacji niezadowolenia, oparte na teorii statystycznej Bayes’a – algorytm wielorękiego bandyty.

Eksperymenty Google Analytics korzystają z algorytmu wielorękiego bandyty

Nazwa pochodzi z jednego z obrazowych przykładów działania tego algorytmu. Wyobraź sobie, że jesteś w salonie gier, masz ograniczoną liczbę żetonów i kilka maszyn typu jednoręki bandyta (takich jak poniżej)

Są maszyny lepsze i gorsze – na niektórych wygrać łatwiej. Nie wiesz jednak jakie są maszyny, które widzisz przed sobą. Twoim celem jest znalezienie tej najlepszej, ale chcesz również wygrać jak najwięcej w trakcie poszukiwań. Potrzebny jest Ci więc algorytm – jak testować maszyny, aby znaleźć tę najlepszą, jednocześnie tracąc jak najmniej pieniędzy (lub zyskując jak najwięcej).

Klasyczny test A/B kazałby Ci wydać tyle samo w każdej. Jeśli jednak tylko jedna maszyna daje Ci zyski, a na pozostałych tracisz bardzo dużo – w ogólnym rozrachunku wyjdziesz na minus.

Algorytm wielorękiego bandyty stara się jednocześnie znaleźć najlepszą opcję, i zminimalizować ryzyko stracenia dużej ilości pieniędzy.

Nie wchodząc w szczegóły, działanie algorytmu jest bardzo proste i odbywa się w kilku krokach. W pierwszym kroku sprawdzamy każdą z maszyn w takiej samej ilości rozgrywek. W drugim kroku oceniamy, w której wygraliśmy najwięcej i dla tej maszyny przypisujemy większą wagę – co oznacza, że w trzecim kroku będziemy ją wykorzystywali częściej niż inne. Odbywa się to proporcjonalnie – jeśli maszyna A wygrała 3 razy więcej pieniędzy niż B, dostanie ona w kolejnym kroku 3 razy więcej gier. Kroki 2 i 3 powtarzamy aż do znalezienia najlepszej maszyny.

Analogicznie działają eksperymenty Google Analytics w ich domyślnej formie.

Jeśli wersja A będzie miała 3 razy większą konwersję niż B, dostanie 3-krotnie wyższy ruch w kolejnym kroku. Narzędzie sprawdza konwersję 2-krotnie w ciągu dnia i zmienia podział ruchu na poszczególne wersje.

Klasyczne testy A/B działają odmiennie – w bardzo prosty, intuicyjny sposób po prostu rozdzielają ruch na obie wersje w ustalonych wartościach (najczęściej po połowie, ale można to dowolnie zmieniać).

Testy A/B wieloręki bandyta pozwalają zminimalizować straty

Dzięki swojej konstrukcji test wielorękiego bandyty pozwala na zminimalizowanie ewentualnych strat – ponieważ gorsza wersja ma zawsze przydzielaną odpowiednio mniejszą ilość ruchu. W teorii to idealne rozwiązanie (tak też przedstawiają je twórcy w bardzo technicznej i dokładnej instrukcji na swojej stronie). W praktyce – niekoniecznie. Wieloręki bandyta ma przynajmniej cztery wady, pominięte przez Google w opisie (bardziej: zatuszowane doborem przykładów):

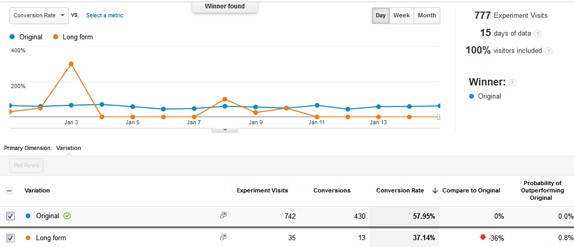

- jeśli przy pierwszym wyborze wersja, która w rzeczywistości jest lepsza będzie miała pecha i dostanie gorszy ruch – w kolejnych krokach będzie dostawała bardzo mały przydział odwiedzających, co nie pozwoli jej pokazać swojej wyższości i w konsekwencji da fałszywe wyniki. W poniższym przykładzie jedna z wersji otrzymała 742 wizyty, konkurencyjna natomiast zaledwie 35. To ogromna różnica. Podjęlibyście się na tej podstawie wnioskowania która wersja jest lepsza?

- powyższy przykład pokazuje kolejny problem – przy takim układzie uzyskanie istotnych statystycznie wyników będzie trwało bardzo długo. Pisałem poprzednio jakie minimalnie próbki powinniśmy stosować w testach A/B żeby miały sens. Tu drugi problem wielorękiego bandyty – zdarza się, że test będzie trwał bardzo długo zanim dostaniemy wiarygodne wyniki – znacznie dłużej niż w klasycznym teście.

- algorytm jest bardziej wrażliwy na dzienne lub tygodniowe wahania konwersji i inne zewnętrzne czynniki – może on np. przydzielić jednej z wersji znacznie większy ruch w godzinach w których większość ludzi dokonuje zakupu, co pozwoli jej uzyskać nieuzasadnioną przewagę.

- wieloręki bandyta jest znacznie trudniejszy do analizy i optymalizacji – ponieważ nie mamy równych próbek, a warunki testu były zupełnie inne dla obu wersji, musimy zdać się na algorytm i zwrócone przez niego wyniki. To spory problem, zwłaszcza, że wyniki te niekoniecznie odpowiadają prawdzie. Bardzo niekomfortowe jest zaufanie algorytmowi o którym wiemy, że może nie działać w każdym przypadku.

Kiedy warto stosować eksperymenty Google Analytics a kiedy klasyczny test A/B

Na szczęście, Google wprowadził możliwość uruchomienia klasycznego testu A/B i zrezygnowania z wielorękiego bandyty, więc nie jesteśmy skazani na ten algorytm.

W niektórych przypadkach warto go jednak wybrać.

Sprawdzi się on najlepiej w dwóch przypadkach:

- Kiedy porównujemy dwie wersje, o których wiemy, że będą miały zupełnie inne współczynniki konwersji. W takim przypadku wieloręki bandyta odkryje różnice znacznie wcześniej niż klasyczny test, dzięki czemu szybciej będziemy mogli wdrożyć lepszą wersję. Z drugiej strony – jeśli wprowadzamy korekty, które tylko minimalnie podniosą współczynniki, znacznie lepiej zdecydować się na klasyczny test.

- Kiedy prowadzimy stałe, nieprzerywane zmiany na naszej stronie lub landing page i co chwila dorzucamy nowe wersje lub wprowadzamy zmiany. Stosując wielorękiego bandytę będziemy mogli utrzymać średni poziom konwersji na wyższym poziomie niż przy standardowym teście. (czytaj: w przekroju całego roku zarobimy średnio więcej. Z drugiej strony – na koniec roku będziemy mieli stronę która ma prawdopodobnie gorszą konwersję niż miałaby przy klasycznym teście – więc zyski w kolejnych latach mogą być niższe.)

Podsumowując, algorytm wielorękiego bandyty stosowany w eksperymentach Google Analytics może się sprawdzić w przypadku prowadzenia nieprzerywanych testów naszej strony bądź sklepu, zwłaszcza, jeśli zależy nam na jak największej średniej sprzedaży lub konwersji.

Przyda się też do przetestowania radykalnych zmian. Jeśli jednak zależy nam na stopniowym poprawianiu pojedynczych elementów strony i szybkim wybraniu lepszej wersji do dalszych poprawek, możemy też pozwolić sobie na trochę niższe średnie wyniki w danym miesiącu, aby w kolejnych odrobić to sobie z nawiązką dzięki wdrożeniu lepszej wersji – lepiej sprawdzą się klasyczne testy A/B.